-

DeepSeek最新多模态大模子:Janus-Pro-7B腹地部署完好意思指南

发布日期:2025-03-05 09:14 点击次数:62专题:DeepSeek为何能搬动巨匠AI圈

起首:小蔡AI现实室

最近DeepSeek王炸持续,刚刚出了火爆巨匠的R1大模子,但还有大招没放!

就在刚刚,准备在多模态大模子正掀翻新一轮技能立异海潮!

DeepSeek新出的Janus-Pro-7B系列当作业界首个剖析-生成一体化架构的顶端模子,完结了:

🔥 五大颠覆性上风 ✅ 视觉问答准确率卓绝GPT-4V ✅ 文生图质地卓绝DALL·E3、Stable Diffusion 3 ✅ 单卡即可初始的高效推理 ✅ 企业级数据狡饰安全保险

本教程将带您完成15分钟极速部署,R1大模子独一你机器够,表面上也不错部署哦。

技俩地址:https://github.com/deepseek-ai/Janus?tab=readme-ov-file#simple-inference-example-1

模子地址:https://huggingface.co/deepseek-ai/Janus-Pro-7B/discussions

环境条目

操作系统: Linux/Windows (保举 Ubuntu 20.04+)

Python: 3.8+

CUDA: 11.7+ (需与PyTorch版块匹配)

GPU: 显存 ≥16GB (Janus-Pro-7B需≥24GB)

存储空间: ≥30GB 可用空间

快速部署

1. 克隆代码库

git clone https://github.com/deepseek-ai/Janus.gitcd Janus

2. 创建捏造环境

conda create -n janus python=3.8 -yconda activate janus// 这一步也不错使用pycharm代替

3. 安设依赖

pip install torch==2.0.1+cu117 --index-url https://download.pytorch.org/whl/cu117pip install -r requirements.txtpip install -e .[gradio] # 安设Gradio膨大

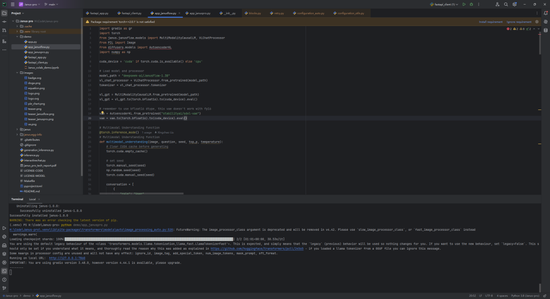

安设完成后如下:

模子下载

设施一:使用 huggingface-cli 用具

安设下载用具

pip install huggingface_hub

下载完满模子(保举)

# 下载7B版块到指定目次huggingface-cli download deepseek-ai/Janus-Pro-7B \ --local-dir ./models/Janus-Pro-7B \ --resume-download \ --cache-dir ./cache

下载指定文献

# 下载配置文献huggingface-cli download deepseek-ai/Janus-Pro-7B config.json --local-dir ./models# 下载中枢模子文献huggingface-cli download deepseek-ai/Janus-Pro-7B pytorch_model.bin --local-dir ./models

下载参数阐扬

| | | | | --- | --- | --- | | 参数 | 阐扬 | 示例 | | --local-dir | 指定下载目次 | --local-dir ./models | | --cache-dir | 设立缓存旅途 | --cache-dir ./cache | | --resume-download | 断点续传 | 自动续传中断的下载 | | --revision | 指定版天职支 | --revision main |

设施二:代码自动下载

from transformers import AutoModelForCausalLM# 自动下载到缓存目次model = AutoModelForCausalLM.from_pretrained(“deepseek-ai/Janus-Pro-7B”)# 指定腹地旅途(需先通过huggingface-cli下载)model = AutoModelForCausalLM.from_pretrained(“./models/Janus-Pro-7B”)

使用示例

加载腹地模子

model_path = “./models/Janus-Pro-7B” # 指向下载目次processor = VLChatProcessor.from_pretrained(model_path)model = MultiModalityCausalLM.from_pretrained(model_path).to(“cuda”)

常见问题

下载速率慢

使用国内镜像源:

HF_ENDPOINT=https://hf-mirror.com huggingface-cli download...

开启多线程下载:

huggingface-cli download ... --workers 8

文献校验失败

实施完满性校验:

huggingface-cli download ... --force-redownload

技能阐扬

模子文献结构:

Janus-Pro-7B/├── config.json├── pytorch_model.bin├── tokenizer_config.json└── special_tokens_map.json

缓存机制:默许缓存旅途为 ~/.cache/huggingface/hub,可通过 --cache-dir 自界说

手动下载

看望HuggingFace仓库

下载Janus-Pro-7B模子文献

解压到腹地目次 ./models/Janus-Pro-7B

使用示例

多模态剖析

# inference_demo.pyimport torchfrom janus.models import MultiModalityCausalLM, VLChatProcessormodel_path = “./models/Janus-Pro-7B”processor = VLChatProcessor.from_pretrained(model_path)model = MultiModalityCausalLM.from_pretrained(model_path).to(“cuda”)# 构建对话conversation = [ { “role”: “<|User|>”, “content”: “\n描述这张图片的本体”, “images”: [“sample.jpg”] }, {“role”: “<|Assistant|>”, “content”: “”}]# 解决输入并生成反馈inputs = processor(conversations=conversation)outputs = model.generate(**inputs)print(processor.decode(outputs[0]))

文生图功能

# generate_image.pyfrom janus.utils import generate_imageprompt = “夕阳下的雪山,山眼下有蓝色的湖泊”generate_image( model_path=“./models/Janus-Pro-7B”, prompt=prompt, output_dir=“./outputs”, num_images=4)

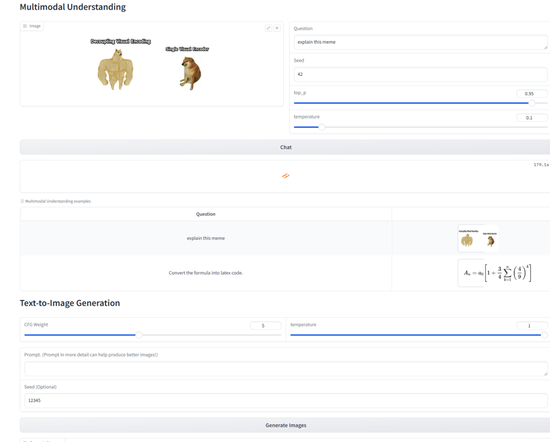

Gradio 腹地演示

# 启动文本交互界面python demo/app_text.py --model-path ./models/Janus-Pro-7B# 启动多模态界面python demo/app_multimodal.py \ --model-path ./models/Janus-Pro-7B \ --port 7860

看望 http://localhost:7860 使用交互界面

常见问题

显存不及

尝试减小max_new_tokens参数(默许512)

使用低精度花样:model = model.half()

图像生成质地欠安

检讨模子版块(保举Janus-Pro-7B)

诊疗CFG权重(5-7规模)

加多并行采样数目(parallel_size=16)

依赖闭塞

冷漠使用官方指定版块:

pip install torch==2.0.1+cu117 pip install transformers==4.33.2

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

攀扯裁剪:李桐